今天短视频平台上,几千上万点赞的关于 DeepSeek 的内容,大部分都是忽悠你的。

DeepSeek 太火了,以至于原来教你做短视频的、做个人 IP 的,甚至教你线下开店的自媒体老师们,连年都不过,在老家的厕所里录视频教你用 DeepSeek 赋能。

连 DeepSeek V3 和 DeepSeek R1 都没搞懂,张嘴就“用 DeepSeek 美化照片太牛了”。

那些做视频的人根本不懂,只是因为蹭这个有流量。

这篇文章,写给头脑清晰的朋友。

(确保你头脑清晰或者希望自己这样,否则下面的截图可能会误伤到你)

我昨天在校友群里稍带“讽刺性”的给在做号的同学说了几个选题方向

昨晚有群友试了一下,分分钟过千曝光……

希望正在读这篇文章的你,不是这类内容的受众之一。

DeepSeek 这波热门,最有价值的是 R1(也就是那个推理思考过程)以及推理思考后的答案。

如果只是用 DeepSeek,它并没有比别的 AI 工具在使用体验上强多少。

所以那些上来就教你“用 DeepSeek 写脚本”、“用 DeepSeek PS 照片”、“用 DeepSeek 做个人知识库”的,都是“……”。

如果你真的希望了解 AI、DeepSeek 会给你带来什么影响,那么你应该关注的是 DeepSeek R1,它才是改变技术和世界的东西;

但如果你只是想跟一下热点,不让自己太“out”,那么你就更必须得关注 DeepSeek R1 才行,否则你会露怯,反倒更丢人;

所以,你关注对了么?

你能分清楚普通 DeepSeek 和 R1 的区别了么?

你知道为什么 R1 引发全球瞩目了么?

你知道为什么所有用过 R1 的人都陷入深深地自我怀疑了么?

不知道也没事,它其实很简单。

我开工第一天的晚上,做了一场两个半小时的直播,从“大模型基础”开始讲起,(我个人感觉)通俗易懂的讲了一遍“ DeepSeek R1 为什么这么强,它对我们有什么影响”。

这是校友昨天上午听直播前对 R1 的感受:

到晚上听直播回放后,实现乾坤大挪移:

如果你错过了,也没关系。这篇文章把直播的关键信息给大家做一番总结,让你也能更清晰的认知 DeepSeek R1。

直播的关键信息:

- DeepSeek为什么这么强?

- 推理模式、强化学习是什么?

- 为什么私有部署不靠谱,蒸馏是什么?

- 对普通人有啥影响,还需要学习提示词么?

- 怎么流畅的用上DeepSeek?

DeepSeek R1 为什么这么火?

原因很简单,就两个字:便宜。

这里的“便宜”是面向所有人的:

- 对全球的大模型创业者来说,训练研发成本降到了 10%;

- 对全球的大模型研究者来说,所有研究细节开源免费试用;

- 对全球的大模型使用者来说,不花钱就能用上付费 ChatGPT 同水平的智能。

R1 这样的模型,2024 年 10 月 ChatGPT 就上线了。

名字叫 o1,需要充值 20 美元/月的 Plus 才能使用,并且限量、不显示思考过程。

以及 OpenAI 这个 Gou 公司闭源、不介绍任何技术细节,搞得全球的科研人员都很烦躁。

DeepSeek 春节前发布 R1 这样的: 模型、数据、权重全部开源;线上版本免费不限量使用;展示全部思考推理过程。

能不炸么!

从国外火回国内的起点是这个,但是真正能持续爆火的原因,是 R1 实在是太太太太太太太太强了!

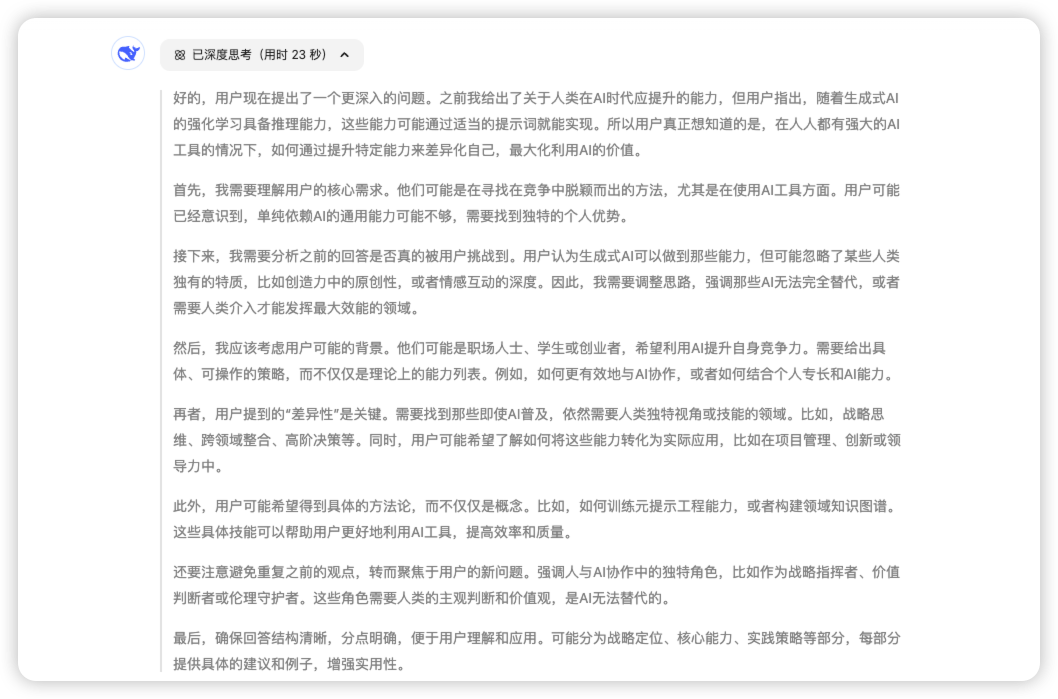

随便截图一个 DeepSeek 的思考过程:

在此基础上生成的答案,又是「逆天」级别

那么,如此强大的 AI,怎么做到极致性价比呢?

从大模型训练方法讲起

我用通义听悟总结了直播回放这部分的内容,直接复制粘贴吧。

(AI 总结有些偷懒,详细的回答在文末有直播回放的获取方式)

大模型训练过程中的主要阶段有哪些?微调阶段对大模型的影响是什么?

直播总结:主要阶段包括预训练和微调。预训练阶段生成预训练模型,之后进行微调以得到更精准的模型,并通过人工验校来提升模型的质量。在微调阶段,给定的内容质量和人工打分/校验决定了大模型回答问题的水平。这意味着人类对于模型好坏判断的标准直接限定了大模型的发展水平。

预训练模型参数量的巨大意味着什么?

直播总结:拥有4000亿个参数的预训练模型就像一个人要掌握所有学科知识并应用到建设祖国中,所需消耗的算力和资源非常庞大,这也是成本高昂的原因之一。

MoE模型是如何降低成本和提高效率的?

直播总结:MOE模型采用多专家协作模式,将参数分散到多个模型上,每个模型针对特定领域优化,这样既能节省资源,又能更好地处理跨学科问题,降低训练和推理过程中的成本。

DeepSeek在训练R1模型时,问答对儿是如何生成的?这种AI生成的训练内容如何降低成本?

直播总结:问答对是通过AI生成的,具体过程是使用引导性提示词让deepseek v3生成带有过程推理和分析的QA对进行训练。成本降低体现在两个方面:一是训练内容由AI生成,降低了人工生产成本;二是deepseek v3模型本身具备一定的对错判断标准,在人工校对时能够更高效地进行验证和修正。

推理是什么?为何如此强大?

下面依然是来自 AI 对直播的总结

deepseek v3模型为何具备天然的推理能力和对错判断能力?强化学习是如何帮助DeepSeek v3实现强大推理能力的?

直播总结:deepseek v3在早期版本中就采用了code模型进行训练,尤其是针对编程语言的学习,使它能够从一开始就获得基本的对错判断能力。在合并了chat模型和code模型后,这种强推理能力被赋予了整个模型。强化学习是DeepSeek v3训练过程中采用的关键技术,类似于阿尔法狗打败柯洁事件中所展现的非传统人类棋谱策略,让模型通过学习和实践来优化决策,而非依赖于大量的历史数据背诵。

这些机器人通过比赛学习到了什么?

直播总结:机器人学会了两件事情:一是如何下棋并赢得比赛,即知道了赢得比赛的方法和正确错误的判断标准;二是能根据历史数据推断出每一步棋对应的结果,并了解这一步棋如何导向最终的胜负,这实际上是一种因果推理的过程。

强化学习中self play是什么意思?

直播总结:self play是指让机器人自己与自己进行对弈,通过不断的游戏来学习和提升,利用自身的胜负判断条件来进行推理和学习。

强化学习具体是怎么运作的?

直播总结:在强化学习中,系统会给出一个问题和答案,并给出明确的对错判断标准。例如,让大模型去做数学题、下象棋或编写程序,系统具备完全正确的评判标准,产生大量训练语料后,大模型通过自我对弈和回顾复盘,逐渐学习到判断好坏的标准。

大模型的语言文字表达能力是如何涌现出来的?

直播总结:大模型首先学会了数学和一些领域知识的正确错误判断标准,然后将这种能力应用于语言理解中,发现也能判断文字表达的优劣。DeepSeek的R1通过自身生成的大量语料进行训练和迭代,最终拥有了强大的文字表达能力,这是强化学习带来的“涌现”效应,即在大量信息和条件变化下产生的新能力。

手机/电脑部署的“平替”为什么不靠谱?

这里涉及到一个叫做“蒸馏”的概念。

你能在自己电脑或者手机上部署的 DeepSeek R1,下载的模型都带着一个distill-qwen。

它的意思是,你用的模型,是用 DeepSeek R1 教会了推理的通义千问模型。

咱不是说通义千问的模型不行,但是它肯定不如 DeepSeek V3。

以及,能在手机电脑上运行的模型,不会超过 14B。

DeepSeek 官网用的 R1 的底摸是 671B。

先别管B是什么意思,671 是 14 的接近 50 倍。

相当于你让一个知识面只有 1/50 的模型,学会了奥数的推理方法。

所以,直接不用试了,浪费时间毫无意义。

关于蒸馏的详细内容,直播中有详细的介绍,文末拿回放获取方式。

对普通人的影响?

总结两句话:

- 普通人有了一个可以免费学习表达的对象;

- 普通人想要变强必须提升表达能力。

这里我来稍微多说一下 DeepSeekR1 时代有效的表达是什么,其他的内容自己看直播回放。

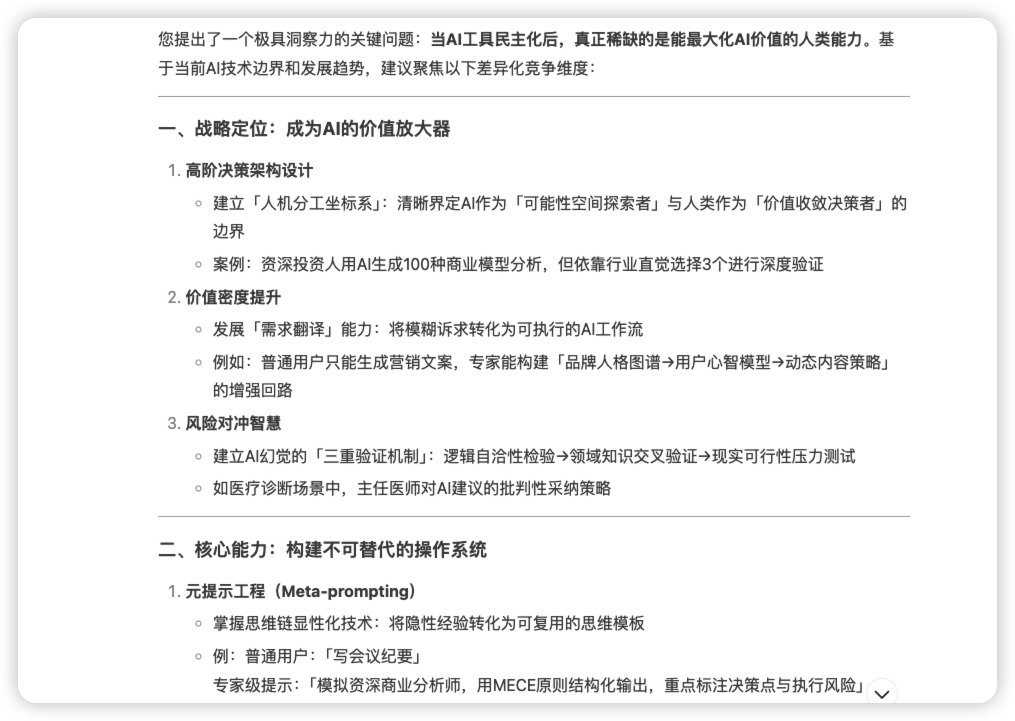

什么是提问的指向性,并为何重要?如何设置有指向性的提问?

直播总结:提问的指向性是指在表达时要有明确的目的、诉求或动机,让接收方能清晰地了解说话人的意图。

缺乏指向性的问题就如同无目的地说话,不仅浪费对方时间,也容易导致沟通无效。

在AI交互中,明确的指向性能够让AI更好地理解和执行用户的指令,实现更精准的结果输出。设置指向性提问时,需要在坐标轴上确定起点和终点。

例如,写文案既可以作为工作的终点目标,也可以作为实现转化、吸引流量等终点的起点。

因此,在提问时要具体说明文案的目的,比如是为了完成KPI还是为了产品转化,这样AI才能根据明确的指向性生成符合要求的内容。

直播回放视频&逐字稿总结

我把直播回放放在知识星球了,扫码领券加入领取。

星球内容很多,进去以后往前翻一翻,2 月 5 日发的主题。